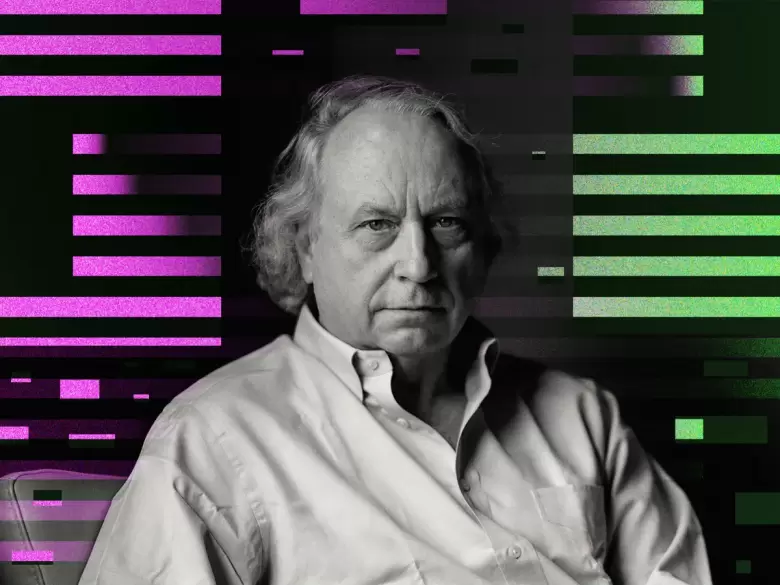

El investigador de robótica y experto en inteligencia artificial Rodney Brooks asegura que hemos estado sobreestimando enormemente los grandes modelos de lenguaje de OpenAI, en los que se basa su exitoso chatbot ChatGPT.

En una entrevista con IEEE Spectrum, Brooks argumenta que estas herramientas "son mucho más estúpidas de lo que pensamos, sin mencionar que están muy lejos de poder competir con los humanos en cualquier tarea a nivel intelectual". En general, dice, somos culpables de muchos pecados de predecir mal el futuro de la IA .

Para resumir, ¿la IA está lista para convertirse en el tipo de inteligencia artificial general (AGI) que podría operar a un nivel intelectual similar al de los humanos?

"No, porque no tiene ningún modelo subyacente del mundo", dijo Brooks a la publicación. "No tiene ninguna conexión con el mundo. Es una correlación entre el lenguaje".

Verificación de la realidad

Los comentarios de Brooks sirven como un valioso recordatorio de las limitaciones actuales que afectan a la tecnología de IA, y lo fácil que es imbuir su salida con significado a pesar de que fueron diseñados para simplemente sonar, en lugar de razonar, como humanos.

"Vemos a una persona hacer algo, y sabemos qué más puede hacer, y podemos emitir un juicio rápidamente", dijo a IEEE Spectrum . "Pero nuestros modelos para generalizar de un desempeño a una competencia no se aplican a los sistemas de IA".

En otras palabras, los modelos de lenguaje actuales no son capaces de inferir lógicamente el significado, a pesar de que lo hacen sonar como si pudieran hacerlo, lo que puede confundir fácilmente al usuario.

"Para lo que son buenos los modelos de lenguaje grande es para decir cómo debería sonar una respuesta, que es diferente de cómo debería ser una respuesta", dijo Brooks.

Completamente mal

El investigador dijo que ha estado experimentando con grandes modelos de lenguaje para ayudarlo con la "codificación arcana", pero se encontró con algunos problemas serios.

"Da una respuesta con total confianza, y en cierto modo lo creo", dijo Brooks a IEEE Spectrum . "Y la mitad de las veces, está completamente mal. Y paso dos o tres horas usando esa pista, y luego digo, 'Eso no funcionó', y simplemente hace esta otra cosa".

"Ahora, eso no es lo mismo que inteligencia", agregó. "No es lo mismo que interactuar. Es buscarlo".

En resumen, Brooks cree que las iteraciones futuras de la tecnología podrían terminar en algunos lugares interesantes, "pero no en AGI".

Y dados los riesgos que implica tener un sistema de IA que reemplace la inteligencia de un ser humano, probablemente sea mejor así.